guides

Artem Vysotsky

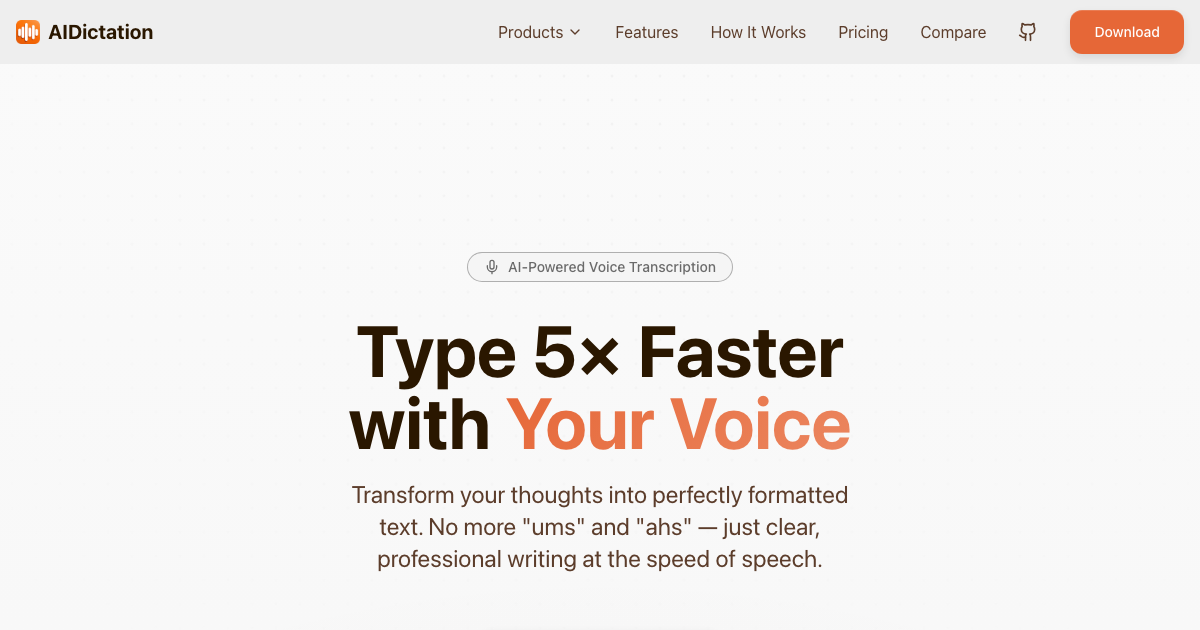

Best Dictation App for Mac in 2025: I Tested Them All So You Don't Have To

Tired of clunky dictation apps that eat your RAM and require accounts just to try? I tested every major Mac dictation app to find the best one.

Read Article